Después de ver tanta ciencia ficción que se siente cercana, por primera vez el cine debate se centró en un documental. Vimos “Sesgo codificado” (“Coded bias”), dirigida por Shalini Kantayya y estrenada en 2020. La primera parte de la charla pensamos en las diferencias y similitudes entre ficción y documental a la hora de acercarse a pensar lo que está pasando.

Durante el debate, algunos nombraron conflictos con el modo de narrar de los documentales, en particular respecto a la inclusión de partes “actuadas”. Eso nos llevó a hablar de los propios prejuicios y de la importancia de tomar conciencia de que nadie está libre de sesgos. El tema que plantea este documental es qué pasa cuando esos sesgos pasan a formar parte de un programa, de un código, que se muestra como una verdad objetiva.

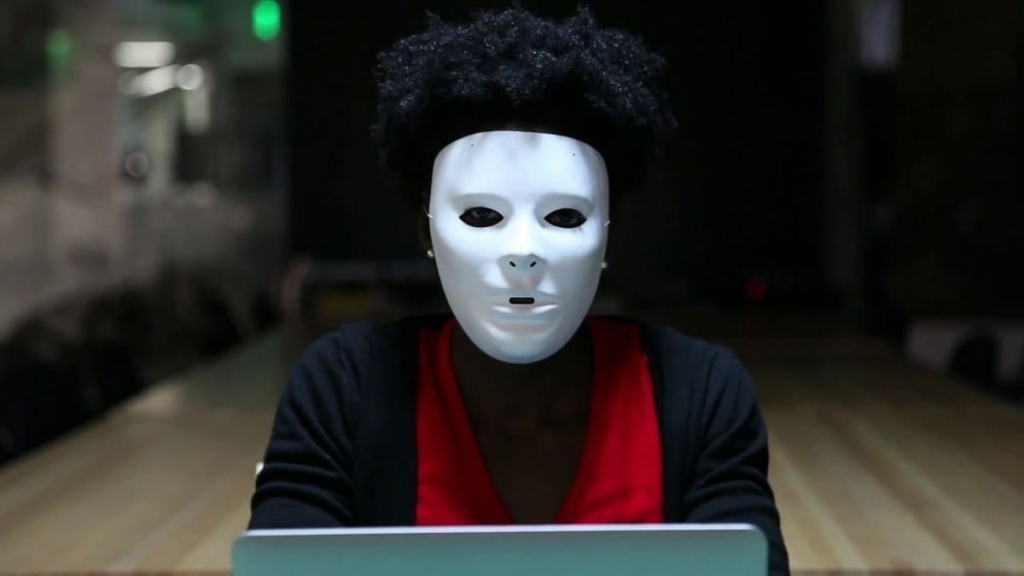

Un mensaje que queda claro con “Sesgo codificado” es la importancia de contar con equipos diversos, que incorporan otras voces. Un buen ejemplo aparece en el comienzo de la película, cuando Joy Buolamwini cuenta cómo, realizando un proyecto, descubrió que un programa de reconocimiento facial no funcionaba con su cara hasta que utilizaba una máscara blanca. Había sido entrenado mayormente con hombres blancos.

También charlamos de cómo “envejeció” esta peli de 2020: la IA de la que se habla es previa a los modelos generativos. Incluso mencionan cómo muchas ideas sobre IA nos vienen de la ciencia ficción, cuando en realidad se trata simplemente de matemáticas, sin pensamiento mágico. Reflexionamos sobre hasta dónde sigue siendo verdadera esa frase.

A pesar de que tiene unos añitos, algunos mencionaron como algo impactante todas las cosas que ya se hacían con IA: seleccionar personal, otorgar créditos, identificar posibles sospechosos o manifestantes, incidir en campañas electorales…

En muchos de los casos mostrados se utilizan para cuestiones delicadas, sobre las que siempre es difícil decidir y hacerse cargo. De ese modo, la decisión de echar o contratar, liberar o dejar en prisión, ya no recae sobre una o más personas, sino que de algún modo se delega a un programa. La pregunta sobre quién es responsable por esas decisiones queda abierta.

Notamos cómo esa pregunta, relacionada con cuestiones éticas, reaparece en todos los debates sobre estas tecnologías y es central también en muchas de las ficciones. En ese sentido, además de recordar varias de las pelis que vimos en el cine debate, mencionamos, como ejemplo más claro, “Minority report”.

Durante la charla comentamos cómo los argumentos que presenta la peli, que quizás apuntan a distintos públicos, pueden perder fuerza al unirse. En algunos casos plantea que el uso de herramientas de IA es inaceptable por cuestiones éticas relacionadas, por ejemplo, con la privacidad; en otros momentos muestra ejemplos de errores que prueban que no serían confiables porque se equivocan.

Una pregunta que deja planteada el documental, después de mostrar distintos casos en los que se vulneran derechos ciudadanos, es si es posible una IA que refleje los valores democráticos con los que nos identificamos. La película desarrolla una mirada crítica que alerta sobre los peligros que traen asociados los avances de la tecnología. Ese posicionamiento, necesario y urgente, quizás lleva a que sea difícil pensar usos positivos, o imaginar formas en las que se pueda intentar usar estas herramientas para transformar las desigualdades, en vez de profundizarlas. Cómo imaginar oportunidades de transformación sin perder la mirada crítica es una de las grandes preguntas que nos planteamos.